企業AI人工智慧的管理及法遵趨勢

- 資料發布日期:113-08-27

- 最後更新日期:113-08-27

文/洪志勳(萬國法律事務所合夥律師)

近期隨著NVIDIA黃仁勳訪臺,將我國AI熱潮提升至新高點,AI話題深入社會各個角落。觀察這幾年的AI演進,從AlphaGo大戰韓國棋王、Open AI推出人工智慧聊天機器人程式ChatGPT及各式各樣生成式AI與判別式AI問世,AI的發展是一把照亮新時代路徑的熊熊火炬。

從網路邁入AI時代

在網路時代使用搜索引擎(如Google)進行資料檢索時,每個使用人須先預設「檢索關鍵字」、「過濾」關鍵字所檢索的資料、「分析」資料及「彙整」資料;然而,在AI時代,使用人只要會「下達指令」給AI工具,AI即會自動執行「關鍵字設定」、「過濾」、「分析」及「彙整」資料等動作,大量減少人力的投入。

基於上述AI的特性,企業開始將AI應用於大規模的數據整理及分析,進而提出諸多應用。例如,我國金融業已將AI應用於消費者行為分析、智能客戶服務、風險預警等,然而,企業內部導入AI應用,將面臨何種管理議題?是否應遵循相關法令?更是每個企業主關注議題。

AI技術發展的核心

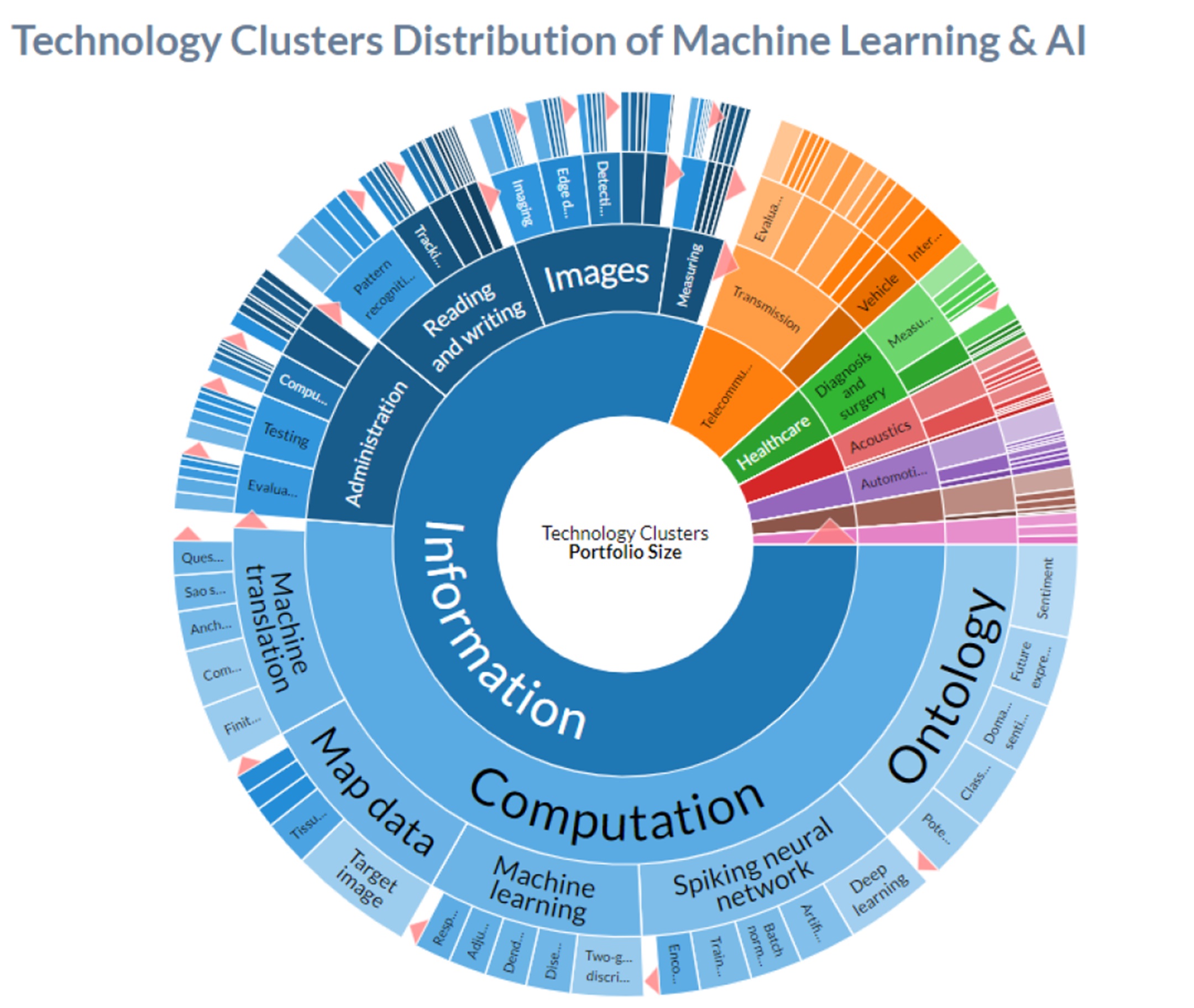

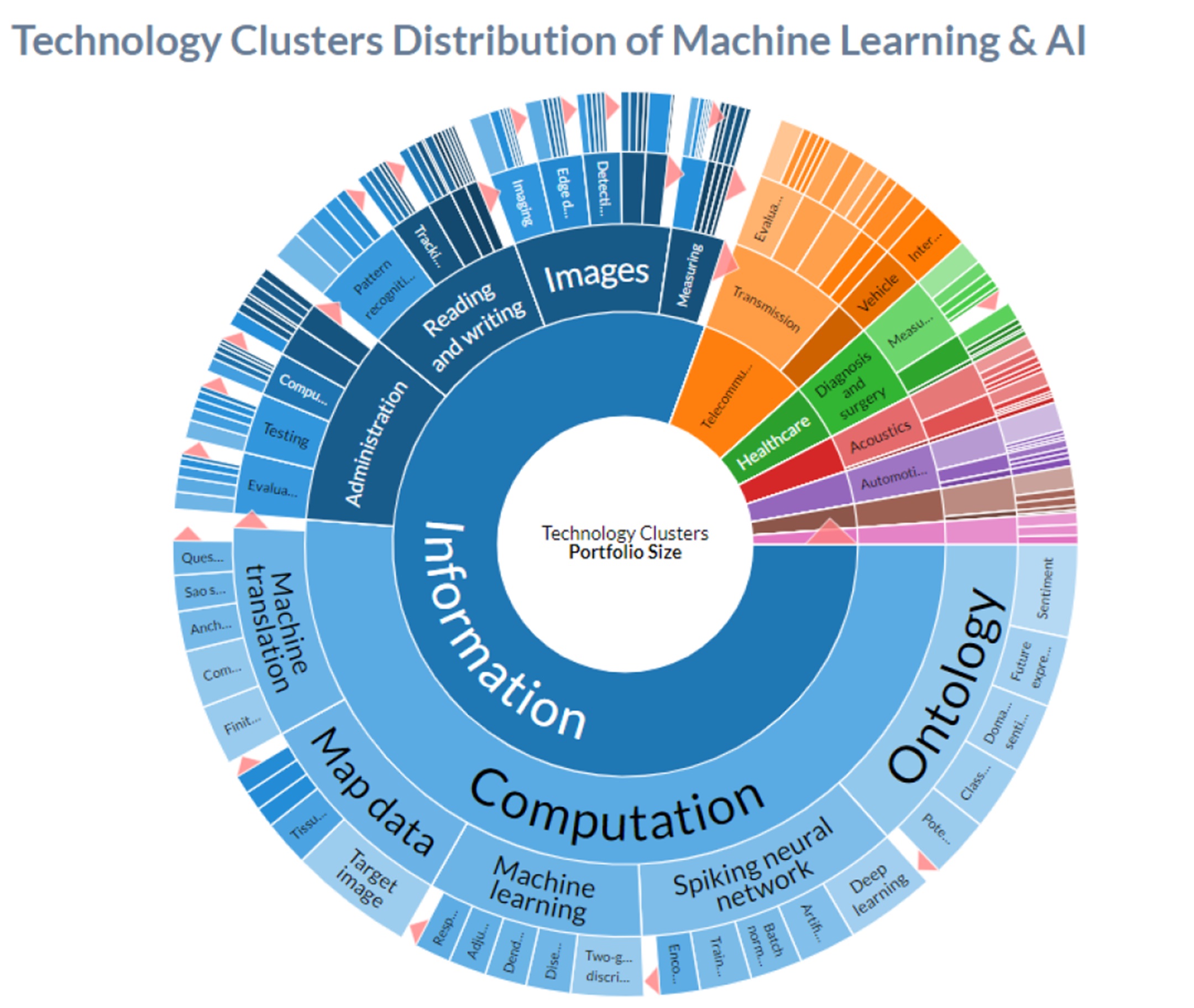

從LexisNexis PatentSight+之AI技術專利分析圖,可以發現AI技術的核心即在於資訊分析(Information Computation),且該資訊分析的主要細部內容,更是耳熟能詳的機器學習(Machine Learning)、類神經網路學習(Spiking Neural Network)、深度學習(Deep Learning)等技術領域。

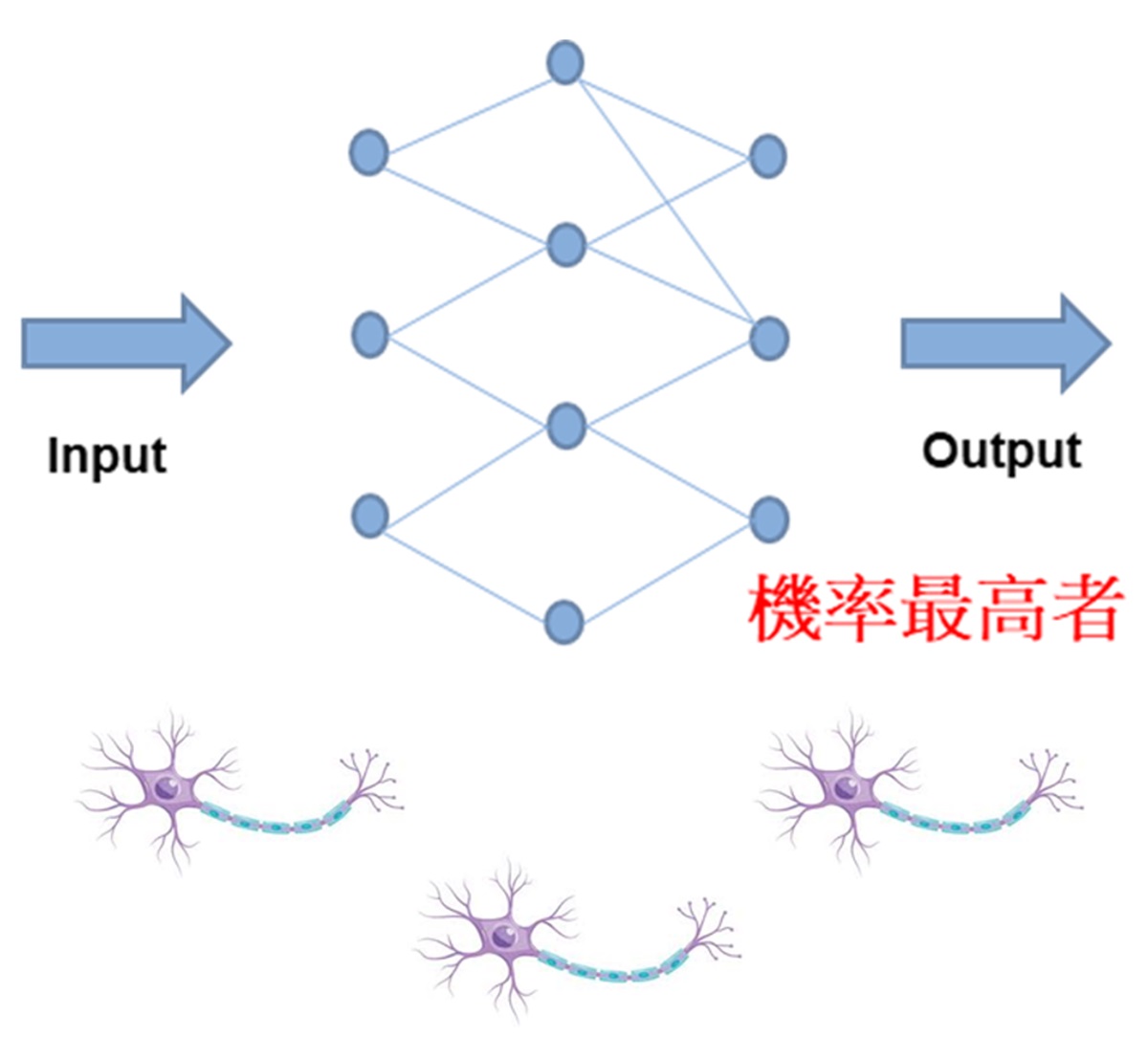

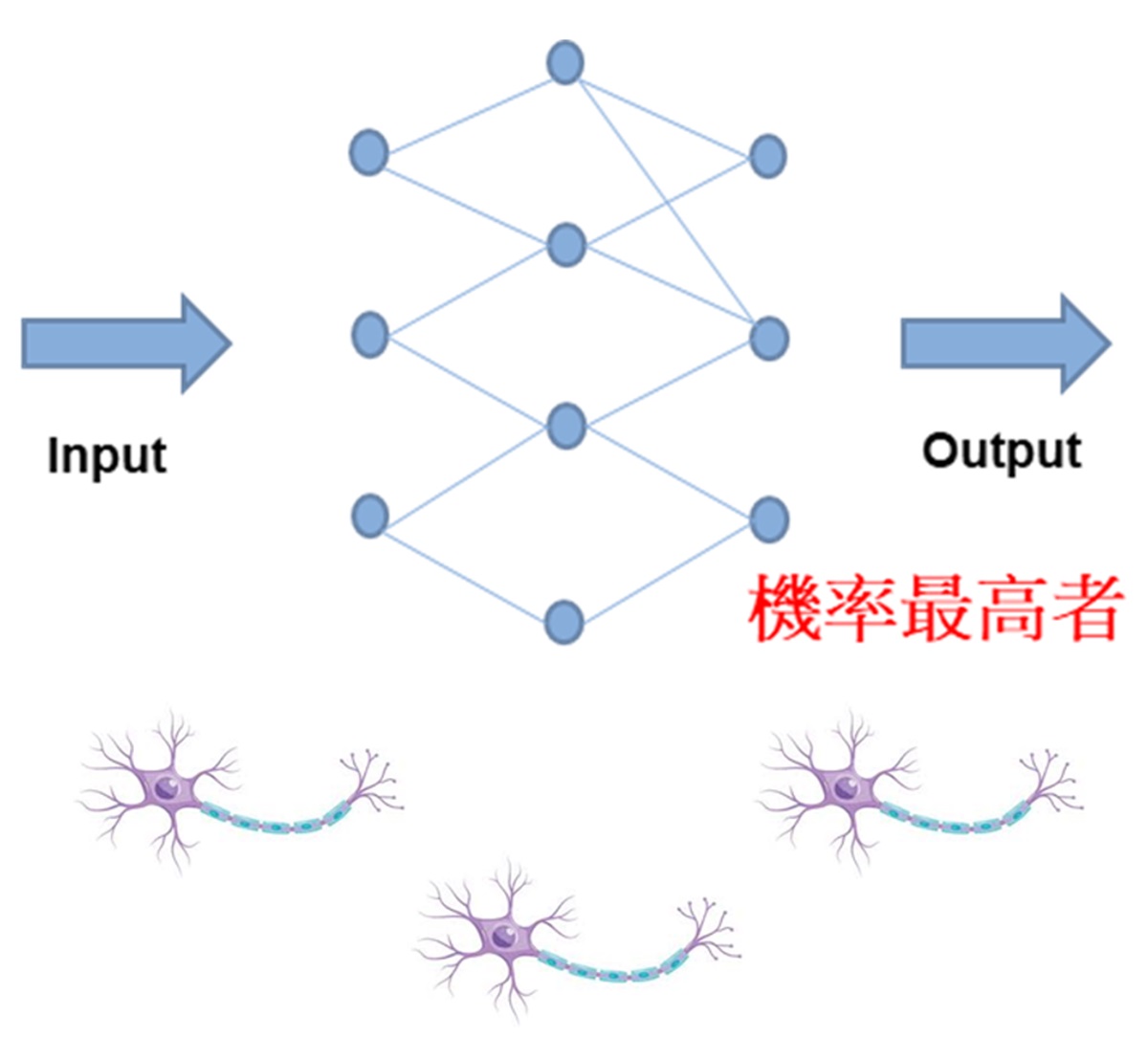

現實生活中存在諸多因素,且每個因素間具有關聯性,關聯性被建立即可形成一個決策系統,當有不同的指令(Input)投進該系統時,經過系統計算,即會產出一個結果(Output),而這個結果就是系統認為最符合該指令所對應的答案。因為每個點會受其他點的影響,而產生不同的結果,這種結構彷彿人體的神經元,不同的神經元藉由突觸進行訊號傳遞,進而產出人的決策系統,此概念稱為「類神經網路」,也是目前AI主要運作架構。

AI衍生的企業管理議題

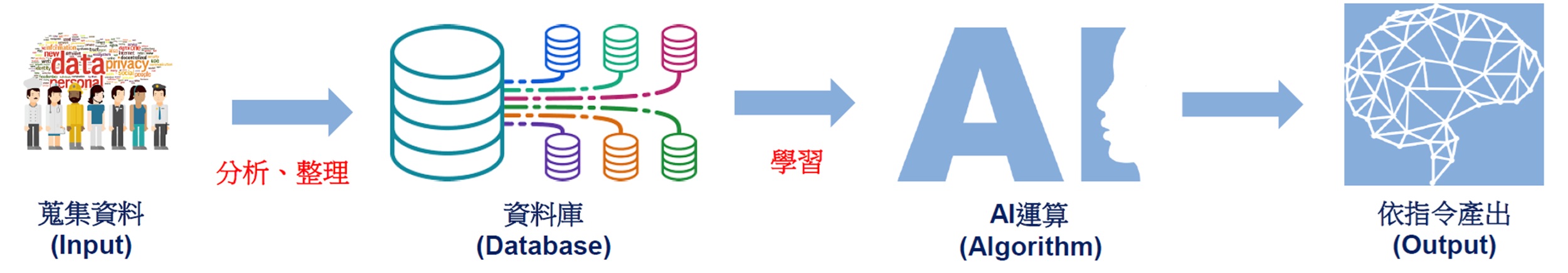

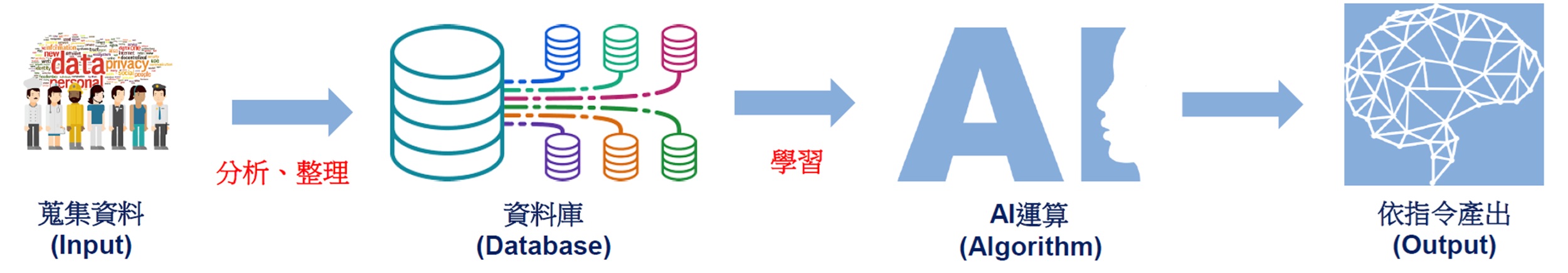

AI系統的建置,需要瞭解不同因素(事件)間的關聯性,進而依據不同指令,產生最符合該指令的結果。如果希望建置一個能回答所有問題的AI系統,此系統需要蒐集各式各樣資料,從資料中分析不同因素的關聯性。因此,開發AI系統的企業,可能會面臨下述管理議題:

企業保存的資料相當有限,如果要讓AI系統的學習效果變得更好,需要投入更多資料,這時該如何取得更多資料?

現行網路發達且資料量多,企業可以擷取網路資料供AI系統學習,然而網路資料是否可以毫無顧忌任意抓取?提醒企業主,網路資料若有註記著作權保留聲明(例如,未經授權,禁止轉載),若無視該保留聲明,逕自抓取資料供AI系統學習,只要資料著作權人能證明該企業有未經授權即抓取資料行為,著作權人得對該企業提起侵害著作權訴訟,此已有外國司法判決可參考。

企業可否使用外部AI工具執行對客戶負有保密義務的工作項目?

AI系統需要資料餵養以進行學習,當使用者上傳新資料至AI系統時,該新資料會成為AI系統學習的對象,且存放在AI系統的資料庫中,故企業員工未經客戶同意,即將客戶機密新產品文件上傳至AI系統,客戶即可對該企業追訴違反保密義務的法律責任。對此,行政院通過「行政院及所屬機關(構)使用生成式 AI 參考指引」,明確訂定「業務承辦人不得向生成式 AI 提供涉及公務應保密、個人及未經機關(構)同意公開之資訊,亦不得向生成式 AI 詢問可能涉及機密業務或個人資料之問題」等規定。

使用AI工具產出的成果,企業是否可就該成果主張智慧財產權?

企業使用AI系統工具執行業務,在執行過程中,使用AI系統工具衍生諸多成果(例如,生成式圖檔),企業對該成果是否可主張任何智慧財產權(例如,主張該圖檔著作財產權歸屬於該企業)?對此,實務上存有不同見解,歸屬於操作AI系統工具之人所有、歸屬於AI系統工具(將AI系統視為虛擬之人),或者歸屬於開發AI系統工具的開發者所有。針對前述問題存有諸多討論,在2023年美國法院曾做出判決,認為AI系統非屬「人類」,著作權法只保護人類所為的創作,進而認定AI系統所生成的圖檔,不受著作權保護。我國法院目前尚無類似判決見解,司法實務對此議題的發展值得關注。

企業面臨的AI法遵議題

AI系統建構在大量資料的分析處理(意即大數據),藉由學習(如機械學習、類神經網路、深度學習)等方式建置AI系統運算機制,讓AI系統得依使用者下達的指令,進行運算並產出AI系統認為最合適的結果,針對「AI運算」部分,該運算發生於遠端的超級電腦,一般使用者不會清楚該運算機制如何分析、運算及產出。簡言之,該AI運算對使用者而言,就是一部深不可測的黑盒子。假設一情境,如果AI系統的開發者於開發過程中,在AI運算程式中納入個人偏見,導致運算結果受其偏見影響,例如,開發者為開發一銀行用戶信用評等系統,因開發者心中存有「黑人等於高風險」偏見,並將其引入該信用評等系統,最終導致任何黑人使用該系統,皆會得到「低」信用評等的運算結果。針對前述的假設情境,此行為是否貶抑人性尊嚴,有損「以人為本」普世價值觀,進而需制定相關法令予以規範。

開發AI系統工具 已是不可逆的趨勢

在全球積極發展AI技術過程中,皆會碰觸到上述議題,然觀諸美國、英國、日本等國的立法管制架構,可發現大都採用「先指令、後立法」方式,主要原因係現行AI技術處於發展階段,若在發展初期即設立嚴格管制法令,讓AI技術發展受限制,或扼殺AI技術創新的可能,且發展過程需創設何種新的法律議題,各國多處於觀察階段,故外國立法例方會採用「先指令、後立法」的立法架構。對此,我國亦採用相同的立法架構,行政部門已開始通過相關指引,例如「行政院及所屬機關(構)使用生成式 AI 參考指引」、「金融業運用人工智慧(AI)指引」。除前述指引外,我國亦在積極研議「AI 基本法(草案)」,期將永續發展、人類自主、隱私保護、資安與安全、透明可解釋、公平不歧視及問責等7大基本原則,明文納入「AI基本法」規範 。

依據McKinsey Digital發布的「The economic potential of generative AI」統計資料顯示,在2030年至2060年間,人類現行社會50%職業可能被AI所取代。面對AI時代,企業使用、開發AI系統工具,已是不可逆趨勢,我國行政部門尚在規劃AI相關指引及基本法草案,企業仍應積極關注相關動態發展,倘企業已投入相當資源進行AI系統工具開發,更應儘早掌握相關指引及草案對於AI系統開發者的要求,降低企業AI系統所面臨的衝擊。